Table des matières

ToggleEt si chaque avancée technologique, y compris les modèles d’intelligence artificielle, restait soumise aux mêmes limites que ses prédécesseuses ?

Dans les années 60, un musicien souhaitant produire un effet d’écho n’avait que deux options, à savoir :

- Jouer dans une caverne naturelle pour exploiter sa réverbération ;

- Utiliser un écho à bandes, un dispositif qui enregistrait le signal sur une bande magnétique avant de le rejouer avec un léger décalage.

Dans les deux cas, la solution était encombrante, coûteuse, et loin d’être pratique.

C’est en 1969 que les premiers circuits Bucket Brigade Devices (BBD) ont vu le jour. Ils ont été conçus comme une alternative analogique plus compacte et abordable. Le principe est simple mais ingénieux : une chaîne de condensateurs se transmet le signal d’un composant à l’autre à chaque impulsion d’horloge, à la manière d’une brigade humaine se passant des seaux d’eau pour éteindre un incendie – d’où le nom. Chaque passage introduit une légère dégradation du signal (un peu d’eau est perdue à chaque transfert). Avec le temps, l’original devient méconnaissable.

Cette analogie illustre parfaitement ce qu’on appelle le model collapse en IA : un phénomène où les modèles se dégradent lorsqu’ils se nourrissent trop de leurs propres productions. C’est notamment ici qu’apparaissent les limites de l’intelligence artificielle.

Prenons l’exemple d’un modèle d’intelligence artificielle entraîné pour améliorer la résolution des images. Pour ce faire, on lui fournit deux types de bases de données :

– un ensemble A d’images dégradées ;

– un ensemble B composé des mêmes images, parfaitement claires.

L’objectif de l’IA est d’apprendre à reconstruire les images claires à partir des versions dégradées. Ensuite, elle compare son résultat avec l’image d’origine, pour vérifier si le travail est correct. Elle recommence, encore et encore, jusqu’à obtenir un niveau de restitution satisfaisant.

Or « satisfaisant » n’est pas « parfait ».

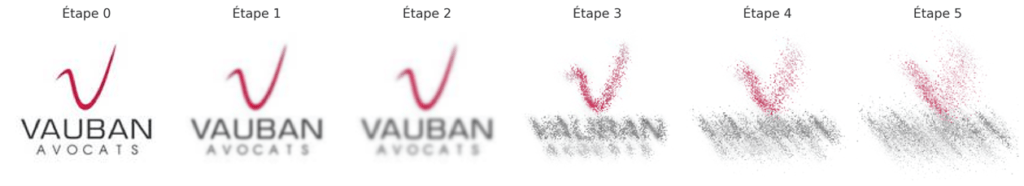

Si cette IA est ensuite réentraînée sur ses propres sorties ou sur des données générées par d’autres IA faute de données fraîches, elle risque de se retrouver piégée dans une boucle de dégradation, produisant des résultats de moins en moins fidèles.

Ce principe s’applique tout autant aux modèles de texte qu’à tout autre domaine où l’IA est utilisée. En clair, si l’IA est entraînée sur un volume trop faible de données ou sur des données mal filtrées, elle développera des biais ou produira des résultats de moindre qualité. À l’inverse, un volume trop important de données mal filtrées peut également conduire à des dérives. Si certaines données sont surreprésentées dans la base d’entraînement, l’IA en déduira des régularités biaisées. Par exemple, si sur 1000 images, 600 sont rouges, elle aura tendance à considérer que toute image, quelle que soit sa couleur d’origine, devrait être rouge.

Contrôles fiscaux et IA : l'opacité en question

Dans un article publié en 2022 par le ministère de l’Économie (« Détection des fraudes : l’IA fait son entrée à Bercy »), nous apprenions que des algorithmes étaient désormais utilisés pour détecter des fraudes potentielles à partir de vastes bases de données. Mais une incertitude demeure : sur quelles données ces modèles d’intelligence artificielle ont-ils été entraînés ?

Le contribuable, pourtant seul propriétaire de ses données juridiques, comptables et fiscales, n’a jamais — à notre connaissance — donné un consentement éclairé pour que ces données soient utilisées à des fins d’apprentissage machine.

L’administration est-elle coutumière de ce type de procédé ? Nous ne nous permettrons pas de l’affirmer. En revanche, l’exemple ancien de la télédéclaration mérite d’être rappelé.

Présentée à l’origine comme un simple outil de simplification, la télédéclaration s’est rapidement imposée comme un standard. Ce que peu de contribuables avaient perçu à l’époque, c’est qu’ils prenaient eux-mêmes en charge une tâche autrefois accomplie par un agent public, en saisissant directement leurs données fiscales sur les serveurs de l’administration.

Maître Damien Guerard, ancien bâtonnier de Reims, avait un jour évoqué — sur le ton de l’humour — une forme de « travail forcé ». Si l’anecdote prête à sourire, elle révèle néanmoins, à travers ce glissement silencieux, la facilité avec laquelle une logique administrative peut, en quelques années, transformer un outil pratique en mécanisme systémique. Et c’est précisément ce type de dérive qu’il convient de prévenir lorsqu’il est question d’IA.

Évidemment, rien ne permet de dire que l’administration utilise les données des contribuables telles quelles. D’aucuns pourraient nous opposer que l’entraînement s’appuie sur des données anonymisées, agrégées, ou issues d’un panel restreint. Or, nous venons de souligner en quoi ces solutions sont, elles aussi, potentiellement sources de biais ou de dégradations à long terme.

Cette zone grise soulève une vraie difficulté : si un modèle d’IA est déployé sans validation indépendante ni traçabilité de son entraînement, comment garantir qu’il ne se dégrade pas au fil du temps ? Comment éviter que des modèles se réentraînent partiellement sur leurs propres résultats, ou sur des signaux produits par d’autres IA, créant ainsi une boucle de rétroaction déviante — ce fameux model collapse ?

Utilisation de l'IA en entreprise : encadrement juridique et cohérence des pratiques

Le recours à l’intelligence artificielle par les entreprises, notamment dans des domaines sensibles comme la fiscalité, la comptabilité ou la gestion juridique, soulève des questions importantes de cohérence, de responsabilité et de gouvernance. Si l’IA peut être un levier d’efficacité, elle nécessite une vigilance particulière quant à la qualité de son entraînement, à l’usage des données, et à l’encadrement des solutions fournies par des prestataires.

L’accompagnement par un avocat, notamment en droit fiscal ou en droit des sociétés, permet d’apporter un cadre juridique structurant à ces pratiques. Il s’agit par exemple d’aider l’entreprise à vérifier la robustesse des modèles d’intelligence artificielle qu’elle utilise, à anticiper les risques liés à des décisions automatisées, ou encore à clarifier contractuellement les conditions d’accès, d’utilisation et de valorisation des données internes.

Ce rôle de conseil est également utile pour assurer un dialogue éclairé avec les prestataires d’IA : poser les bonnes questions, comprendre les limites techniques, identifier les zones d’opacité, et inscrire l’utilisation de ces outils dans une logique de conformité durable. Plus que jamais, l’anticipation juridique devient un outil de maîtrise et de cohérence dans l’usage de l’intelligence artificielle en entreprise.

Un outil à encadrer avant qu'il n'apprenne seul

L’intelligence artificielle est un outil formidable. Elle permet déjà de décupler les capacités humaines, d’automatiser l’analyse de volumes de données inaccessibles autrement, et de libérer du temps sur de nombreuses tâches répétitives. Mais comme tout outil puissant, elle doit être maniée avec discernement. L’un des défis majeurs auxquels nous faisons face aujourd’hui n’est pas tant de la contenir que de l’élever — à la manière d’un enfant — sur des bases saines, claires et maîtrisées.

Car si l’IA est appelée à remplacer l’homme dans l’exécution, l’humain doit évoluer et devenir le référent, le gardien de sens, celui qui injecte de l’éthique, de la mémoire, de l’intention. En l’abandonnant à elle-même, on court le risque de la voir dériver, s’auto-alimenter sur des biais, s’éloigner du réel… jusqu’à devenir inutile.

Nous sommes encore aux balbutiements de cette technologie. L’IA apprend selon une logique logarithmique : elle progresse d’abord lentement, puis de plus en plus vite à mesure que ses capacités s’accroissent. Cette accélération future impose, dès maintenant, une réflexion lucide et structurée sur ce que nous voulons lui transmettre — et sur le rôle que nous entendons jouer à ses côtés.

Car ce n’est pas l’IA qu’il faut craindre, mais l’absence d’encadrement humain, à un moment où elle apprend encore… de nous.

Partager mon besoin avec un avocat

Téléchargez la plaquette de présentation de notre cabinet